大数据量生成脚本及导入策略

发布时间:2014-09-05 13:50:23作者:知识屋

大数据量生成脚本及导入策略

性能测试过程中,如果需要构造一张表大数据量基础数据时,有两点需要注意:如何生成unl文件(此文件是后缀为.unl的数据文件,格式为,按表列分割的数据记录,例如:10001|33333|),生成的unl文件是否可以一次性导入到数据库相应表中。

为了方便叙述,假设数据库存在表test(id integer,name integer,primary key(id,name))。若想为此表导入1000W条记录,手动insert不现实,一般数据库系统都会提供特定指令,实现数据的导入导出操作,我们可以预先构造好相应格式的unl文件,再调用数据库导入指令,实现数据的快速导入。以Informix数据库为例,数据导入操作的命令为:load from testdata.unl insert into test;现在,剩下的问题就是如何生成一千万行的unl文件了。

了解shell脚本的同学会很快想到使用awk实现,这里也如大家所想,使用awk实现:

[plain]

<span style="">#!/bin/sh

awk 'BEGIN{

dbfile=sprintf("testdata.unl");

for(i=0; i<1000; i++)

{

for(j=0;j<10000;j++)

{

printf "100%05d|9%08d|/n",i,j >>dbfile

}

printf "%d completed./n",i

}

}' /dev/null</span>

这样,会生成一个有1000W条记录的unl文件,于是我们兴冲冲使用“load from testdata.unl insert into test;”指令导入数据,结果发现报错了。因为一次性导入的数据太多,数据库系统的缓存、日志系统空间不够用,无法一次性记录太多的记录(或者因为操作时间太长,直接超时了“Long transaction aborted”)。

有两种解决方案:提高缓存、日志系统大小;缩小单个unl数据量。显而易见,后者更为合理。

如果将一千万的unl分成100小份,每份10W条,就好处理多了。脚本略作修改,如下:

[plain]

<span style="">#!/bin/sh

awk 'BEGIN{

for(i=0; i<100; i++)

{

dbfile=sprintf("mytable%02d.unl",i);

for(j=0;j<100000;j++)

{

printf "100%05d|9%08d|/n",i,j >>dbfile

}

printf "%d completed./n",i

}

}' /dev/null</span>

此时,面对100个文件,要操作一百次,又有点头大。本着偷懒的原则,自然想到使用自动去做。于是,自动导入到test表中的shell脚本也新鲜出炉:

[plain]

<span style="">#!/bin/sh

#生成100条的sql脚本

awk 'BEGIN{

dbfile=sprintf("loadData.sql");

for(i=0; i<100; i++)

{

printf "load from mytable%02d.unl insert into test;",i >>dbfile

}

printf "completed."

}' /dev/null

#执行脚本

dbaccess mydatabank loadData.sql

</span>

当然,如果想更深一步“偷懒”,可以把这些shell放一起,不过要注意可读性,建议再新建一个shell,顺序调用这两个shell,便于后续维护。

(免责声明:文章内容如涉及作品内容、版权和其它问题,请及时与我们联系,我们将在第一时间删除内容,文章内容仅供参考)

相关知识

-

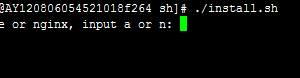

linux一键安装web环境全攻略 在linux系统中怎么一键安装web环境方法

-

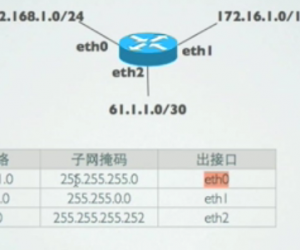

Linux网络基本网络配置方法介绍 如何配置Linux系统的网络方法

-

Linux下DNS服务器搭建详解 Linux下搭建DNS服务器和配置文件

-

对Linux进行详细的性能监控的方法 Linux 系统性能监控命令详解

-

linux系统root密码忘了怎么办 linux忘记root密码后找回密码的方法

-

Linux基本命令有哪些 Linux系统常用操作命令有哪些

-

Linux必学的网络操作命令 linux网络操作相关命令汇总

-

linux系统从入侵到提权的详细过程 linux入侵提权服务器方法技巧

-

linux系统怎么用命令切换用户登录 Linux切换用户的命令是什么

-

在linux中添加普通新用户登录 如何在Linux中添加一个新的用户

软件推荐

更多 >-

1

专为国人订制!Linux Deepin新版发布

专为国人订制!Linux Deepin新版发布2012-07-10

-

2

CentOS 6.3安装(详细图解教程)

-

3

Linux怎么查看网卡驱动?Linux下查看网卡的驱动程序

-

4

centos修改主机名命令

-

5

Ubuntu或UbuntuKyKin14.04Unity桌面风格与Gnome桌面风格的切换

-

6

FEDORA 17中设置TIGERVNC远程访问

-

7

StartOS 5.0相关介绍,新型的Linux系统!

-

8

解决vSphere Client登录linux版vCenter失败

-

9

LINUX最新提权 Exploits Linux Kernel <= 2.6.37

-

10

nginx在网站中的7层转发功能