Linux下安装Hadoop(伪分布模式)

发布时间:2014-09-05 14:23:52作者:知识屋

Linux下安装Hadoop(伪分布模式)

写在前面:在Linux下安装Hadoop时,应注意权限问题,将hadoop的权限赋给非root用户。

本文中未涉及如何在Linux下创建新用户。

第一步,安装JDK

1. 下载 java.sun.com

2. 解压tar.gz的文件

tar -xzvf jdk-7u17-linux-x64.tar.gz

3. 把解压出来的文件夹移动到/usr/local/jdk-1.7目录

mv /usr/local/src/jdk1.7.0_17 /usr/local/jdk-1.7

4. 修改profile

vi /etc/profile

在最后追加

export JAVA_HOME=/usr/local/jdk1.7.0_17

export JRE_HOME=$JAVA_HOME/jre

export CLASSPATH=.:$JAVA_HOME/jre/lib/rt.jar:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

export PATH=$PATH:$JAVA_HOME/bin

5. 使环境变量生效

source /etc/profile

6. 查看当前jdk

update-alternatives --display java

7. 配置默认jdk

update-alternatives --install /usr/bin/java java /usr/local/jdk1.7.0_17/bin/java 300

update-alternatives --install /usr/bin/javac javac /usr/local/jdk1.7.0_17/bin/javac 300

update-alternatives --install /usr/bin/javap javap /usr/local/jdk1.7.0_17/bin/javap 300

update-alternatives --install /usr/bin/javadoc javadoc /usr/local/jdk1.7.0_17/bin/javadoc 300

update-alternatives --config java

如果系统中安装了其他jdk,会提示,选择jdk7

8. 测试

java -version

第二步,安装SSHD服务

ubuntu安装sshd命令:sudo apt-get install openssh-server

ubuntu删除sshd命令:sudo apt-get remove openssh-server

第三步,配置无密登录

(应该非root用户下执行)

ssh-keygen

cd ~/.ssh

mv id_rsa.pub id_rsa_hadoop.pub

touch authorized_keys

cat id_rsa_hadoop.pub >> authorized_keys

第四步,下载Hadoop并解压

解压:tar -zxvf hadoop-1.0.3.tar.gz

移动:mv hadoop-1.0.3 /usr/local/hadoop

更改文件夹chown -R hadoop.hadoop hadoop

创建目录:mkdir /data /data/hadoop

更改文件夹chown -R hadoop.hadoop /data/hadoop

第五步,配置Hadoop

配置 conf/hadoop-env.sh

export JAVA_HOME=/usr/local/jdk-1.7

export HADOOP_LOG_DIR=/data/hadoop/logs

export HADOOP_PID_DIR=/data/hadoop/pids

修改/etc/profile

添加:export HADOOP_PID_DIR=/data/hadoop/pids

配置 core-site.xml

fs.default.name

hdfs://master:8020

hadoop.tmp.dir

/data/hadoop/tmp

配置 hdfs-site.xml

dfs.name.dir

/data/hadoop/name

dfs.data.dir

/data/hadoop/data

dfs.replication

2

dfs.permissions

false

hadoop.job.ugi

hadoop,supergroup

配置 mapred-site.xml

mapred.job.tracker

master:8021

mapred.tasktracker.map.tasks.maximum

2

mapred.map.tasks

2

mapred.tasktracker.reduce.tasks.maximum

2

mapred.reduce.tasks

1

mapred.compress.map.output

true

mapred.map.output.compression.codec

com.hadoop.compression.lzo.LzoCodec

第六步,启动关闭hadoop

bin/hadoop namenode -format (只在第一次启动时需要,用于格式化名称节点)

bin/start-all.sh

使用浏览器访问http://localhost:50070和http://localhost:50030查看Hadoop是否启动成功。

bin/stop-all.sh

(免责声明:文章内容如涉及作品内容、版权和其它问题,请及时与我们联系,我们将在第一时间删除内容,文章内容仅供参考)

相关知识

-

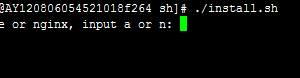

linux一键安装web环境全攻略 在linux系统中怎么一键安装web环境方法

-

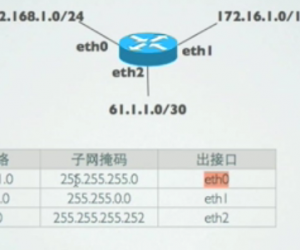

Linux网络基本网络配置方法介绍 如何配置Linux系统的网络方法

-

Linux下DNS服务器搭建详解 Linux下搭建DNS服务器和配置文件

-

对Linux进行详细的性能监控的方法 Linux 系统性能监控命令详解

-

linux系统root密码忘了怎么办 linux忘记root密码后找回密码的方法

-

Linux基本命令有哪些 Linux系统常用操作命令有哪些

-

Linux必学的网络操作命令 linux网络操作相关命令汇总

-

linux系统从入侵到提权的详细过程 linux入侵提权服务器方法技巧

-

linux系统怎么用命令切换用户登录 Linux切换用户的命令是什么

-

在linux中添加普通新用户登录 如何在Linux中添加一个新的用户

软件推荐

更多 >-

1

专为国人订制!Linux Deepin新版发布

专为国人订制!Linux Deepin新版发布2012-07-10

-

2

CentOS 6.3安装(详细图解教程)

-

3

Linux怎么查看网卡驱动?Linux下查看网卡的驱动程序

-

4

centos修改主机名命令

-

5

Ubuntu或UbuntuKyKin14.04Unity桌面风格与Gnome桌面风格的切换

-

6

FEDORA 17中设置TIGERVNC远程访问

-

7

StartOS 5.0相关介绍,新型的Linux系统!

-

8

解决vSphere Client登录linux版vCenter失败

-

9

LINUX最新提权 Exploits Linux Kernel <= 2.6.37

-

10

nginx在网站中的7层转发功能